Однако, как и в случае с обнаружением лучей, список игр, поддерживаемых DLSS сегодня, к сожалению, невелик. Однако в будущем это должно измениться.

Что такое RTX, чем RTX отличается от GTX и что лучше?

Параметры GPU — самый важный аспект сравнения видеокарт. Он определяет основные параметры графического чипа, используемого для сравнения. Эта панель сравнивает RTX 2060 с GTX 1660 TI на основе характеристик графического чипа. Другими словами, он сравнивает модели GPU по количеству ядер CUDA, текстурных блоков, архитектуре, технологическому процессу, базовой тактовой частоте и скорости разгона.

| Сравнение возможностей GPU:. | |||

|---|---|---|---|

| Эквивалентные модели:. | Nvidia GeForce RTX 2060 6GB | Против. | nvidia geforce gtx 1660 ti |

| Модель графического процессора:. | ТУ106-300 (ТУ106) | Против. | ТУ116-400 (ТУ116) |

| Ядра CUDA: против | 1920 | Против. | 1536 |

| GPU: против | 12 нм Finfet | Против. | Нет доказательств. |

| Текстурные блоки: против | 120 | Против. | 96 |

| Архитектура: против | Тьюринг | Против. | Тьюринг |

| Технология процесса: против | 12 нм Finfet | Против. | 12 нм Finfet |

| Базовая тактовая частота: 12 нм Finfet против 12 нм Finfet. | 1365 | Против. | 1500 |

| Тактовая частота ускорения: против | 1680 | Против. | 1770 |

Характеристики памяти являются важным фактором при сравнении. Производительность видеокарты в играх и профессиональных приложениях зависит от производительности, объема памяти и типа. В большинстве случаев, чем выше цена, тем лучше производительность.

Ниже приведена сравнительная таблица, сравнивающая видеокарту GeForce RTX 2060 с картой памяти GeForce GTX 1660 TI. Сравнение производительности памяти, сравнение тактовой частоты, скорость памяти, тип, биты, грудная клетка группы, ритм крови.

Сравнение Скорость памяти: 14000 Мбит/с против 6000 Мбит/с Тактовая частота памяти: 1750 МГц против 1500 МГц Объем памяти: 6144 МБ против 6144 МБ Тип: GDDR6 против GDDR6.

| Техническая поддержка и сравнение характеристик | |||

|---|---|---|---|

| Поддержка CUDA:. | Да | Против. | Да |

| Обнаружение лучей в реальном времени: да | Нет | Против. | Нет |

| Поддержка VR: нет | Нет | Против. | Да |

| Анселл: Да | Да | Против. | Да |

| SLI: Да | Нет | Против. | Нет |

| Physx: Да | Да | Против. | Да |

| GameStream: да | Нет | Против. | Нет |

| ShadowWorks: нет | Да | Против. | Нет |

| ShadowPlay: Да | Да | Против. | Нет |

| Усиление графического процессора: да | 4.0 | Против. | Да |

| DirectX: против | 12 | Против. | 12 API |

| OpenGL: Да | 4.5 | Против. | 4.5 |

| Автобусы. | PCI-Express 3.0 X16 | Против. | PCI-Express 3.0 X16 |

| Сравнение поддержки экрана:. | |||

|---|---|---|---|

| Максимальное цифровое разрешение:. | 7680 x 4320 | Против. | 7680×4320@120 Гц |

| Типовые соединения:. | DisplayPort, HDMI 2.0, USB Type-C, DVI-D Duallink | Против. | DisplayPort 1.4A, HDMI 2.0B, двухканальный DVI-D |

| Поддержка нескольких экранов:. | Да, до 4 | Против. | Да |

| HDCP: Да, до 4 | Да, до 2.2 | Против. | Да, до 2.2 |

| HDMI: Да | Да | Против. | Да |

| Аудиовход HDMI: да | Интерьер | Против. | Интерьер |

⇡# Atomic Heart

Бенчмарк для предстоящей игры Atomic Heart не включает никаких настроек, кроме возможности активировать масштабирование кадров DLSS, при максимальном разрешении экрана 2560 x 1600 пикселей. Обнаружение луча здесь всегда активно. Поскольку Atomic Heart Machine использует DXR для рендеринга двух различных эффектов — тени и отражения света (включая обнаружение нескольких лучей между несколькими зеркальными поверхностями) — тестовая сцена также представляет собой большой вызов для ускорителей, настраивающих чипы с эксклюзивными ядрами RT Ry Является. Старшие модели NVIDIA (GeForce RTX 2080 и RTX 2080 TI) превышают 60 к/с в режиме 1080p, в то время как RTX 2060 и RTX 2070 выжимают 45-55 к/с. Напротив, при разрешении 1440p даже GeForce RTX 2080 TI не смогла достичь порога в 60 к/с, а результаты GeForce RTX 2060 были ниже 30 к/с.

Финальная версия Atomic Heart, вероятно, позволит адаптировать качество эффекта DXR для снижения нагрузки на GPU. Кроме того, у разработчиков еще есть несколько месяцев, чтобы полностью оптимизировать машину. Однако в нынешнем виде игра явно превосходит возможности ускорителя GPU Pascal. Не говоря уже о более низкотехнологичных устройствах серии GTX 10, GEFORCE GTX 1080 TI может делать только 26 кадров в секунду при 1080p и 15 кадров в секунду при 1440p.

При нагрузках, равных атомному сердцу, даже видеокарты GeForce GTX 1660 и GTX 1660 TI имеют преимущество перед большинством моделей предыдущего поколения, хотя они и не оснащены специальными блоками обнаружения лучей. Оба новых ускорителя среднего уровня превосходят GeForce GTX 1080 — невиданный ранее блин архитектуры Pascal. Однако, в любом случае, абсолютной вычислительной мощности чипа TU116 все равно совершенно недостаточно для создания приемлемых кадров.

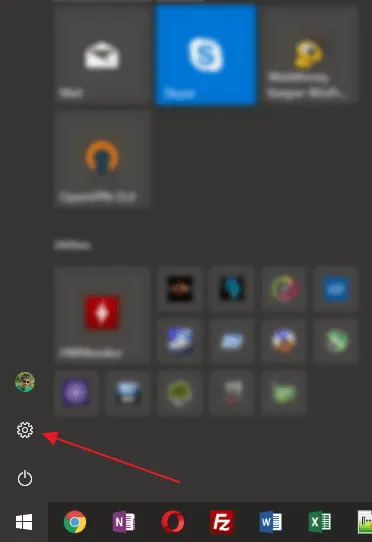

Основы

Все игровые графические процессоры Nvidia относятся к ее собственному бренду GeForce, который начал свое существование в 1999 году с выпуском Geforce 256. С тех пор компания выпустила сотни различных видеокарт в трех последних сериях. Серия GeForce 30 выйдет в 2019 и 2020 годах.

Начиная с сегодняшнего дня, серии GeForce 20 и GeForce 30 состоят исключительно из GPU RTX, а серия GeForce 16 — из видеокарт GTX. Так что же означают все эти буквы? На самом деле, ни GTX, ни RTX не являются аббревиатурами и не имеют конкретного значения как такового. Они предназначены только для маркетинговых целей.

Nvidia использовала похожие двух- и трехбуквенные названия, чтобы дать пользователям общее представление о производительности каждого GPU. Например, на протяжении многих лет производители использовали такие названия, как GT, GTS и GTX, но до сих пор сохранились только GTX и новая RTX.

Что это значит, в чем разница между моделями GTX и RTX и какую из двух выбрать? На все эти вопросы есть ответы, поэтому советуем вам прочитать статью до конца!

Основы

Все игровые графические процессоры Nvidia относятся к ее собственному бренду GeForce, который начал свое существование в 1999 году с выпуском Geforce 256. С тех пор компания выпустила сотни различных видеокарт в трех последних сериях. Серия GeForce 30 выйдет в 2019 и 2020 годах.

Начиная с сегодняшнего дня, серии GeForce 20 и GeForce 30 состоят исключительно из GPU RTX, а серия GeForce 16 — из видеокарт GTX. Так что же означают все эти буквы? На самом деле, ни GTX, ни RTX не являются аббревиатурами и не имеют конкретного значения как такового. Они предназначены только для маркетинговых целей.

Nvidia использовала похожие двух- и трехбуквенные названия, чтобы дать пользователям общее представление о производительности каждого GPU. Например, на протяжении многих лет производители использовали такие названия, как GT, GTS и GTX, но до сих пор сохранились только GTX и новая RTX.

GeForce 20 / 30 против GeForce 16

Во-первых, следует отметить, что Series 20 и 16, то есть новейшие GPU RTX и GTX, основаны на тех же видеокартах Turing, впервые представленных NVIDIA в 2018 году. Они основаны на новейшей архитектуре Ampere.

Однако GeForce 20 и 16 основаны на одной и той же архитектуре, но были выпущены первыми. После их запуска в 2018 году производители хотели сосредоточиться на расширенных возможностях новой архитектуры. В серию вошли графические карты GPU верхнего среднего класса и высокого качества, которые могли подчеркнуть эти особенности, и это были первые модели RTX.

Серия 16, с другой стороны, появилась годом позже. Это произошло потому, что Nvidia должна была предложить более доступное решение для тех, у кого нет возможности потратить более 400 долларов США на видеокарту. Однако эти графические процессоры не обладали вышеупомянутыми расширенными возможностями, поэтому они сохранили старое название GTX.

Однако сегодня GPU GTX фактически слабее RTX, что и было замыслом самих разработчиков. Название RTX было введено в основном по маркетинговым причинам, чтобы новый GPU выглядел как большой шаг вперед, как нечто действительно новое, а само название было вдохновлено важными новыми функциями, введенными в 20-й серии: обнаружение лучей в реальном времени.

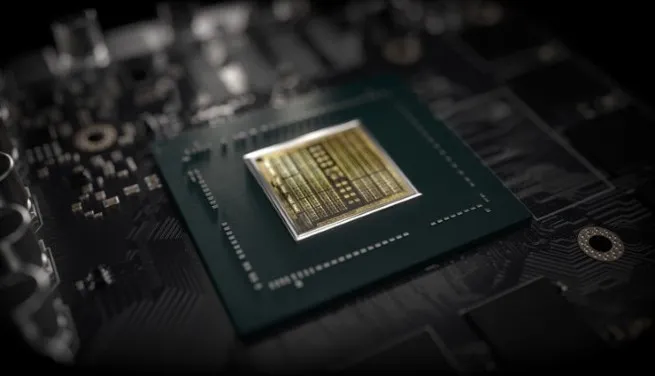

REAT -TIME RAY Обнаружение стало возможным благодаря ядру RT, которое присутствует только в линиях 20 и 30 и отсутствует в серии 16. Кроме того, имеется тензорное ядро, обеспечивающее ускорение работы искусственного интеллекта и улучшенную производительность обнаружения лучей. При этом особое внимание уделяется глубокому изучению игр.

Кроме этих двух ключевых особенностей, разница между видеокартами GTX 16 и графическими процессорами RTX 20 и 30 невелика. Очевидно, что самые дорогие модели RTX имеют больше транзисторов, больше ядер, лучшую память и т.д., и поэтому предлагают более высокую общую производительность, чем более дешевые модели GTX. Однако они не обязательно предлагают более качественную цену.

Так что же это за новые возможности и стоит ли покупать GPU RTX?

Что такое RT ядра?

Как упоминалось выше, ядро RT — это ядро GPU, разработанное специально для фактического обнаружения лучей.

Так что же делает обнаружение лучей в графике видеоигр? Технология позволяет добиться более реалистичного освещения и отражений. Он делает это, рассматривая обратную траекторию радиального пути, что позволяет графическому процессору генерировать гораздо более реалистичное моделирование того, как свет взаимодействует с окружающей средой. Raytracing может выполняться на GPU без RT-ядер, но даже на таких моделях с морской маркировкой, как GTX 1080 TI, производительность просто неприемлема.

Говоря о производительности, обнаружение REAL -TIME RAY существенно влияет на производительность, даже при использовании GPU RTX.

К 2020 году лишь немногие игры поддерживали обнаружение лучей.

На видео выше показано, как выглядит обнаружение лучей в Control (2019). Графические улучшения, обеспечиваемые обнаружением лучей, значительны. Однако эта функция снижает FPS в два раза с постоянных 60 до 30 при использовании высокопроизводительной видеокарты RTX 2070 Super Graphics.

Обнаружение лучей в реальном времени — это серьезный прогресс в игровом процессе, который значительно улучшит графику видеоигр в ближайшие годы. Однако в настоящее время аппаратное обеспечение не работает, и разработчики еще не в полной мере используют эту функцию.

Первый актив не может быть реализован без второго. Это означает, что вы можете играть с низкой трассировкой лучей, но если ваша игра также поддерживает DLSS, вы не потеряете в производительности, а сохраните тот же FPS или даже несколько повысите его.

Nvidia GeForce 10 Series – закатная звезда Золотой эпохи

Когда-то линейка видеокарт Pascal произвела революцию в локальной производительности, увеличив ее на 50% по сравнению с предыдущим поколением микроархитектуры Maxwell. GTX 1060 с 6 ГБ памяти неожиданно стала пользоваться огромным успехом, а владельцы более дорогой GTX 980 кусали локти, поскольку более дорогие видеокарты были дорогим оборудованием с почти одинаковой производительностью. Переход от серии RTX 20 к серии RTX 30 практически идентичен, но подробнее об этом позже.

Тем не менее, серия видеокарт GeForce 10 принесла некоторые фундаментальные инновации.

- Переход на технологический процесс TSMC 16 нм. Графические процессоры Maxwell были построены по техпроцессу 28 нм.

- Поддержка DisplayPort 1.4 и HDMI 2.0b.

- Вычислительные возможности CUDA 6.0 на чипах GP100 и CUDA 6.0 на чипах GP102 (GTX 1080 Ti), GP104 (GTX 1070 и GTX 1080), GP106 (GTX 1060), GP107 (GTX 1050 Ti) и GP108 (GT 1030). 1 вычислительные возможности. Технология многопоточных вычислений на GPU получила значительный толчок в развитии после выхода видеокарт серии GTX 10, что оказало ощутимое влияние на графическую индустрию.

- Увеличение пропускной способности памяти связано с усовершенствованием технологии сжатия цветов дельта-цвета четвертого поколения.

- Для чипов G104 и G102 переключается на видеопамять GDDR5X.

- Оптимизированная асинхронная технология, позволяющая видеокартам на базе Pascal улучшить распределение ресурсов и загрузку GPU.

- Тройное кэширование реализовано на уровне драйвера.

Проще говоря, видеокарты серии GTX 10 быстрее, стабильнее и надежнее. Теплоотдача была снижена, эффективность на ватт повышена, а цена новых моделей осталась такой же, как и у предыдущего поколения.

10-я серия имела огромный успех и все еще имеет своих первых пользователей спустя четыре года после запуска. Согласно статистике Steam, на долю GTX 1060 приходится 10% рынка.

GTX 1050Ti, который когда-то считался королем эконом-класса, находится на втором месте. Поскольку уже выпущено два новых поколения, бабушки не спешат уходить на пенсию. На презентации видеокарт серии RTX30 в сентябре Дженсен Хуанг сказал: «Все мои друзья используют Pascal! Возможно, именно поэтому он произнес фразу «Теперь настало время для обновления». Эта ситуация в первую очередь подтверждает позицию, что времена видеокарт Nvidia серии GeForce GTX10 были в некотором смысле золотыми для игровой индустрии. Но Хуанг прав: прошло время, и лучшие видеокарты того времени уже не могут справиться с современными видеоиграми. Пришло время перейти к следующему шагу.

Всем, кто планирует купить игровой ноутбук, стоит посмотреть это видео:

Здесь подробно рассмотрены различия между популярными видеокартами 10-й и 20-й серий, которые обычно используются в ноутбуках. Разумеется, с тестами в реальных играх.

Nvidia GeForce RTX 20 Series – эпоха лучей и 4К-гейминг

Семейство графических ускорителей Turing, которое принесло с собой технологию трассировки лучей. Для аппаратного ускорения трассировки лучей каждая видеокарта нового поколения получила выделенные RT-ядра. Вторая инновация — тензорные ядра для ускорения функций искусственного интеллекта, глубокого обучения и DLSS. Выделенные тензорные и RT-ядра позволяют графическим процессорам нового поколения достичь шестикратного увеличения производительности при трассировке лучей по сравнению с предыдущим поколением. Без трассировки лучей выигрыш более скромный — 20-30%, в зависимости от сравниваемых моделей и условий тестирования.

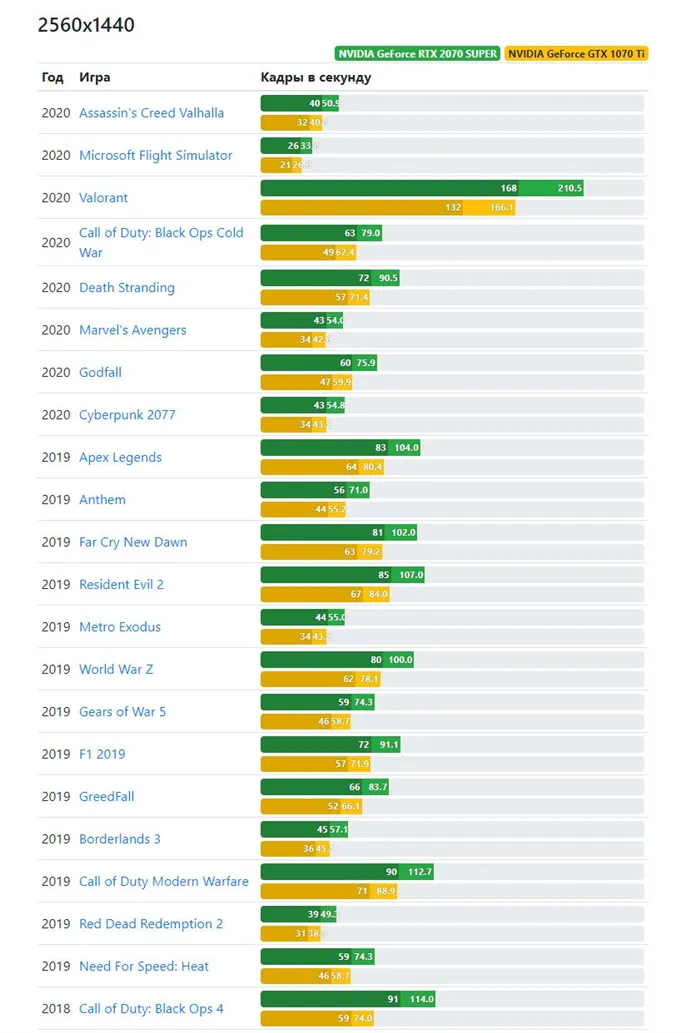

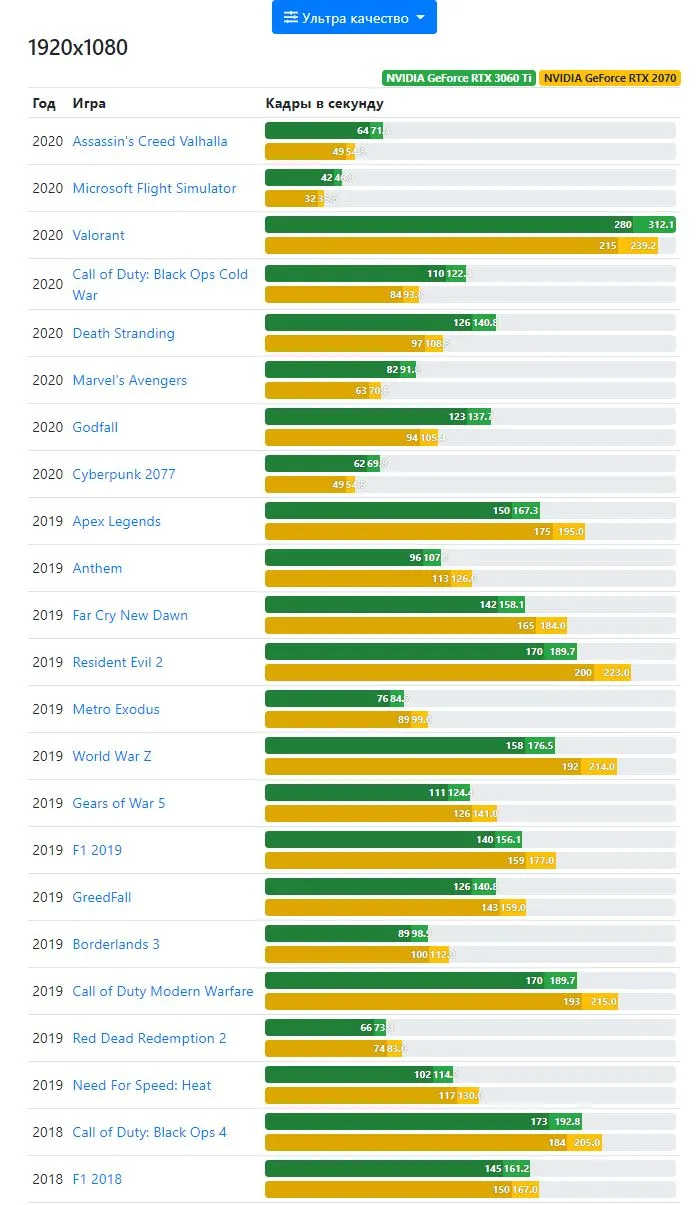

Например, без включенной трассировки лучей RTX 2070 Super лишь на 15-20% быстрее GTX 1070 Ti при тестировании в режиме Full HD (1920×1080):

В Quad HD разница более заметна из-за увеличенной пропускной способности подсистемы видеопамяти:

Аналогичная ситуация наблюдается и при сравнении других моделей. Однако архитектура Тьюринга оказалась весьма успешной и принесла много полезных инноваций:

- Переход на более тонкие 12-нм процессоры позволил снизить энергопотребление и тепловыделение, увеличив производительность на ватт,

- Серия Nvidia GeForce RTX 20 имеет улучшенную технологию нового поколения Variable Rate Shading для оптимального распределения вычислительной мощности на богатые деталями области изображения, повышая общую производительность и стабильность при покадровой графике,

- Графические процессоры Turing получили возможность одновременно обрабатывать данные с плавающей точкой и целые числа, что также повысило стабильность и производительность FPS,

- улучшенная поддержка API DX12,

- переход на видеопамять GDDR6.

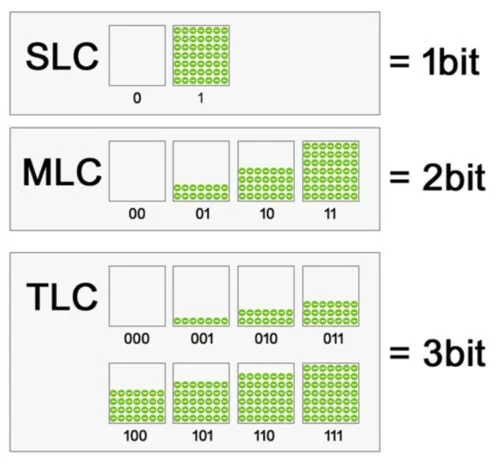

Стандарт видеопамяти GDDR6 оказался значительно быстрее своих предшественников:

| GDDR5 | GDDR5X | GDDR6 | |

| Скорость передачи данных | До 8 Гбит/с | До 12 Гбит/с | До 16 Гбит/с |

| Ширина шины | 512 бит | 512 бит | 512 бит |

| Объем видеопамяти | 12 ГБ | 12 ГБ | 12 ГБ |

| 動作電圧 | 1.5V | 1.35V | 1.35V |

| Плотность микросхем | до 8 Гбит | до 16 Гбит | до 8 Гбит |

| Общая скорость | 512 Гбит/с | 768 Гбит/с | 1024 Гбит/с |

GeForce 30 Series – феноменальный успех и колоссальный дефицит

1 сентября 2020 года грянул гром. На официальной презентации генеральный директор Nvidia Дженсен Хуанг рассказал о новой серии RTX 30 на архитектуре Ampere, которая должна была обеспечить 80% прирост по сравнению с предыдущим поколением. Тем временем бизнесмен продемонстрировал RTX 3070, которая, оказывается, стоит 500 долларов без учета налогов, но по производительности близка к RTX 2080 Ti и даже немного обходит ее. Вы можете убедиться в этом, посмотрев соответствующие видеоролики:

А вот сравнение флагмана последнего поколения с RTX 3080, который даже на 20-30% опережает своего более дорогого предшественника:

Теперь давайте подробнее рассмотрим серию GeForce RTX 30 от Nvidia: какой она была, к чему мы пришли и стоит ли обновлять свой ПК.

Что нового в серии RTX 30?

Производительность не только выросла на 50-80% по сравнению с предыдущим поколением, но Nvidia также внедрила несколько инновационных технологий:

- rtx io. Суть этой технологии заключается в отказе от работы центрального процессора, когда видеокарта имеет доступ к содержимому SSD. Проще говоря, текстуры и все остальные файлы в игре загружаются непосредственно SSD в кадровый буфер видеокарты, минуя центральный процессор. Это значительно повышает производительность и скорость загрузки. Эта технология редко используется в других странах, но она оставит свой след в будущем.

- NVIDIA DLSS 2.0 — это передовая технология эскалации в реальном времени, которая генерирует механическое обучение и изображения более высокого разрешения без увеличения нагрузки на GPU.

- Обновление до графики GDDR6X с удвоенной пропускной способностью, уменьшенной тепловой индукцией и более низким рабочим напряжением.

- отражение nvidia. Эта разработка направлена на снижение задержек в играх с помощью интеллектуальных программных алгоритмов. Подробностей пока нет, но результаты очень впечатляют.

- Samsung переходит на свой самый тонкий 8-нм процессор.

Это значительно ниже заявленной стоимости серии RTX 30 по сравнению с семейством Turing. Рекомендованная цена RTX 3060 Ti составляет 400 долларов США, а RTX 2070 является самой дорогой с точки зрения производительности.

Однако фактическая цена покупки видеокарты Ampere Graphics все равно значительно выше рекомендованной, поскольку NVIDIA не может удовлетворить этот спрос. Если это вас не отпугивает, можете смело брать — новая технология действительно новаторская, как и при переходе от Maxwell к Pascal.

Самой мощной видеокартой Nvidia является RTX 3090, о которой у нас есть подробный обзор.

Эта карта в одночасье обошла RTX 2080 TI, но стоила внушительную сумму денег. Если вам это не дорого, купите его — он достаточно хорош, чтобы играть на экранах с разрешением 4K в течение следующих пяти или шести лет. А пока — спасибо за внимание, и мы скоро это скажем!

Производительность не только выросла на 50-80% по сравнению с предыдущим поколением, но Nvidia также внедрила несколько инновационных технологий:

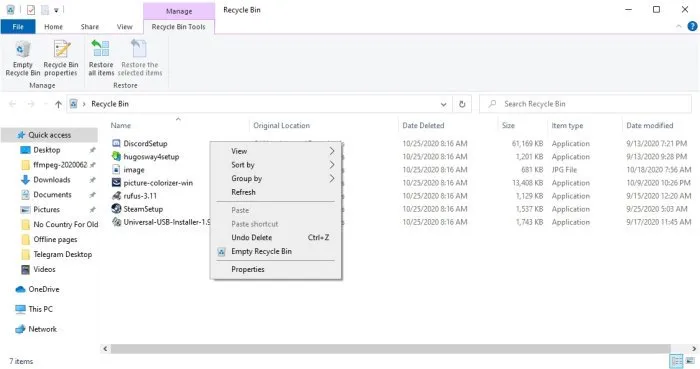

Почему разработчики игр не хотят внедрять технологию

Прошло почти два года с момента распространения видеокарт RTX, но еще не многие игры поддерживают эту технологию. Разработчики очень неохотно применяют его, и официальная информация отсутствует.

Пользователи и некоторые аналитики считают, что одни студии не хотят выделять дополнительный бюджет на внедрение детекции, а другие считают технологию недоработанной. Кроме того, видеокарты RTX еще не завоевали прочную основу на рынке.

Сравнение технических характеристик RTX и GTX видеокарт без учета трассировки лучей

В своей презентации карт серии GeForce RTX компания Nvidia уделила мало слов сравнению производительности с предыдущим поколением. Основное внимание было уделено только отслеживаемости, что полностью игнорирует то, что интересует большинство игроков. Это вызвало волну слухов, как будто Nvidia нечем похвастаться.

Затем появились утечки из презентации, которую Nvidia, предположительно, подготовила для СМИ. Там был представлен график, показывающий производительность новейшей карты GeForce RTX 2080 по сравнению с GeForce GTX 1080. График показал, что новая видеокарта была примерно на 50% эффективнее предыдущей. Конечно, все зависит от конкретной игры, в которой проводится сравнение. Однако было одно событие, и этот рисунок был в разрешении 4K.

Новая технология в GeForce RTX 2080

NVIDIA также предлагает преимущества нового решения DLSS. Deep Learning Super Sampling — это новая технология сглаживания, которая использует тензорные ядра и элементы искусственного интеллекта для лучшей оптимизации качества изображения. Это происходит при одновременном снижении нагрузки на ядра CUDA. Игры, которые поддерживают это, должны достичь впечатляющих результатов.

Сравнение технических характеристик GeForceRTX2080 и GTX1080

Ниже приведена сравнительная таблица, в которой сравниваются технические характеристики видеокарт нового и предыдущего поколений.

| GeForce RTX 2080 Ti | GeForce RTX 2080 | GeForce GTX 1080 | |

| Архитектура | Тьюринг | Тьюринг | Паскаль |

| Процедура | 12 нм NFF | 12 нм NFF | 16 нм |

| Ядро CUDA | 4352 | 2944 | 2560 |

| Ядро RT | 10 Гига лучей | 8 гигабайт | -8 гига лучей |

| Производительность RTXOPS | 78 триллионов RTOPS | 60 триллионов RTOPS | -8 гига лучей |

| Частота чипа | 1350 МГц | 1515 МГц | 1607 МГц |

| VRAM | 11 ГБ GDDR6 | 8 ГБ GDDR6 | 8 ГБ GDDR5X |

| Производительность памяти | 14 Гбит/с | 14 Гбит/с | 10 Гбит/с |

| Шина памяти | 352 бита | 256 бит | 256 бит |

| Полоса пропускания | 616 ГБ/сек | 448 ГБ/сек | 320 ГБ/сек |

| TDP | 250W | 215W | 180W |